{{!completeInfo?'请完善个人信息':''}}

精准高效领先的融资对接服务

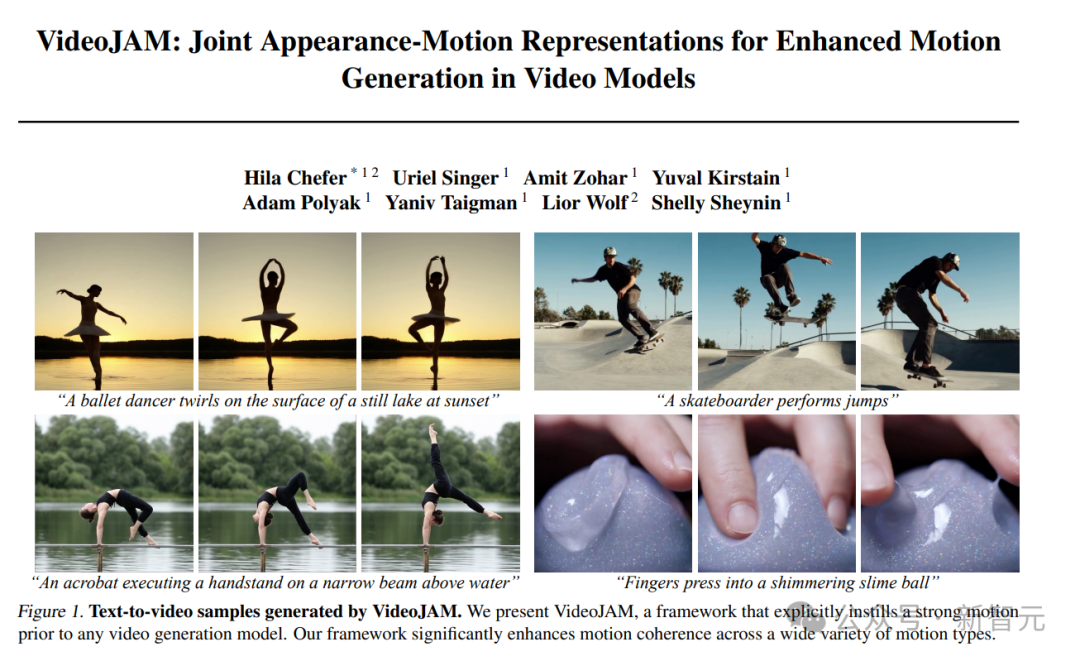

VideoJAM是由Meta和特拉维夫大学研究人员提出的一个新框架,旨在解决AI视频生成中运动连贯性不足的问题。传统视频模型因训练目标偏向外观保真度,导致运动连贯性差。VideoJAM通过修改目标函数,引入显式的运动先验,使模型同时预测外观和运动,从而提升运动理解能力。

Sora生成的男子抛球的视频,可谓是爆笑如雷了;而VideoJAM生成的效果,真实又自然,完全符合物理规律。

从Sora生成的转呼啦圈动作看,它完全没理解这项运动的原理,而VideoJAM已经手拿把掐。

AI视频为何难以捕捉现实动作

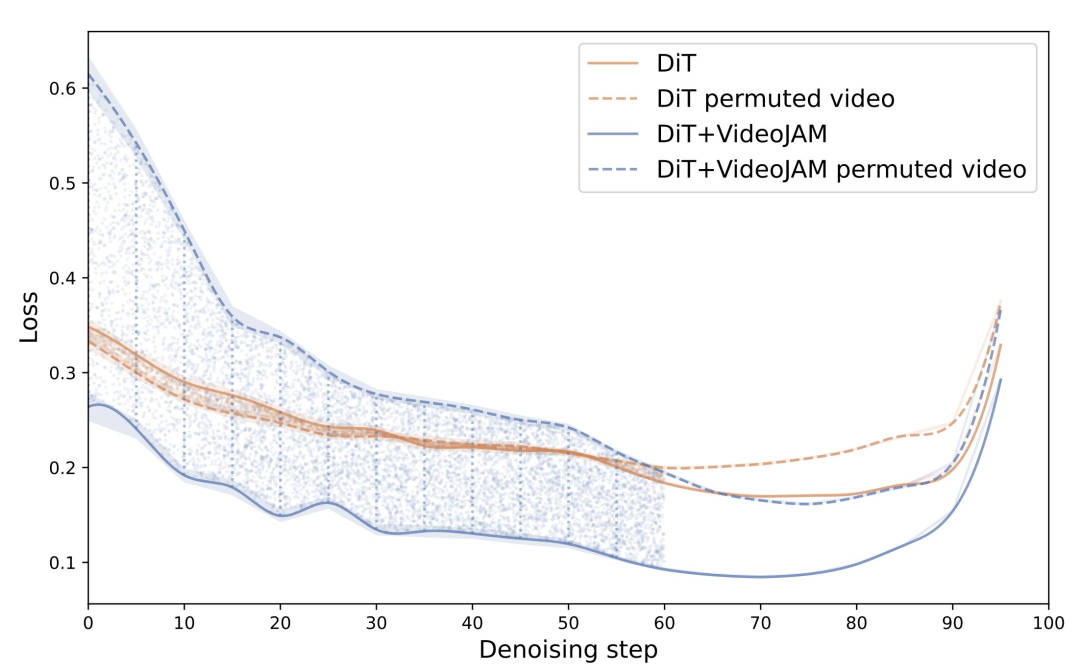

Meta的研究团队发现,当视频帧被打乱时,基于像素的损失几乎不变,这表明,它几乎「对时间不一致性保持不变」。

也就是说,这种局限性源于传统的像素重建目标,它会使模型过度关注外观保真度,而忽视了运动的连贯性。

Meta的解决方案,就是VideoJAM。

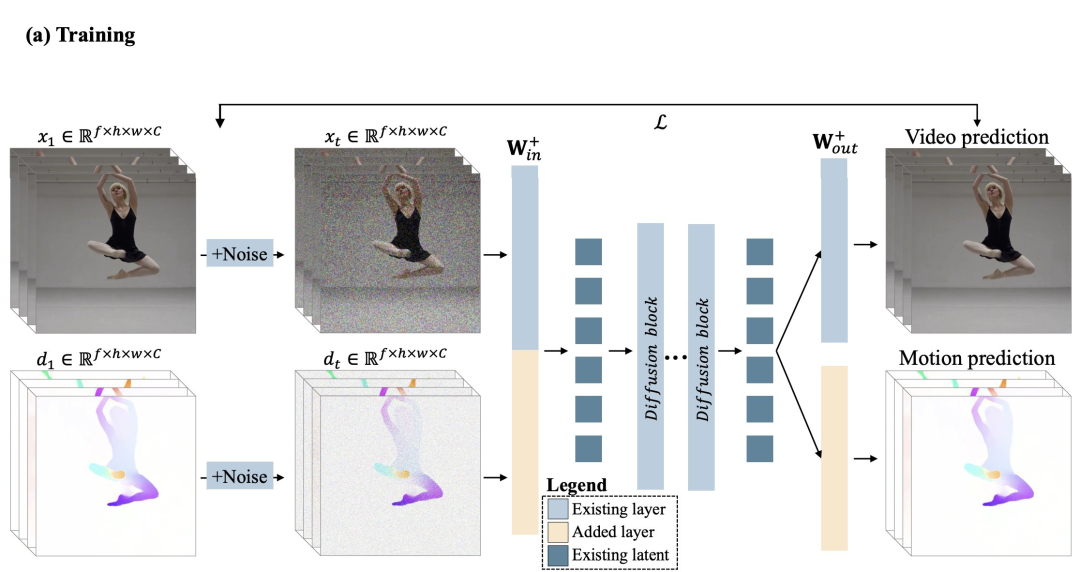

它通过修改目标函数,来引入显式的运动先验:模型从单一的学习表征中同时预测外观和运动。

这种方法,就能迫使模型同时捕捉视觉信息和动态变化,从而提升对运动的理解能力。

具体来说,VideoJAM通过鼓励模型学习外观与运动的联合表征,为视频生成器注入有效的运动预测。

VideoJAM由两个互补的模块组成。

在训练阶段,研究人员将目标扩展为基于单一的学习表征,同时预测生成的像素及其对应的运动。

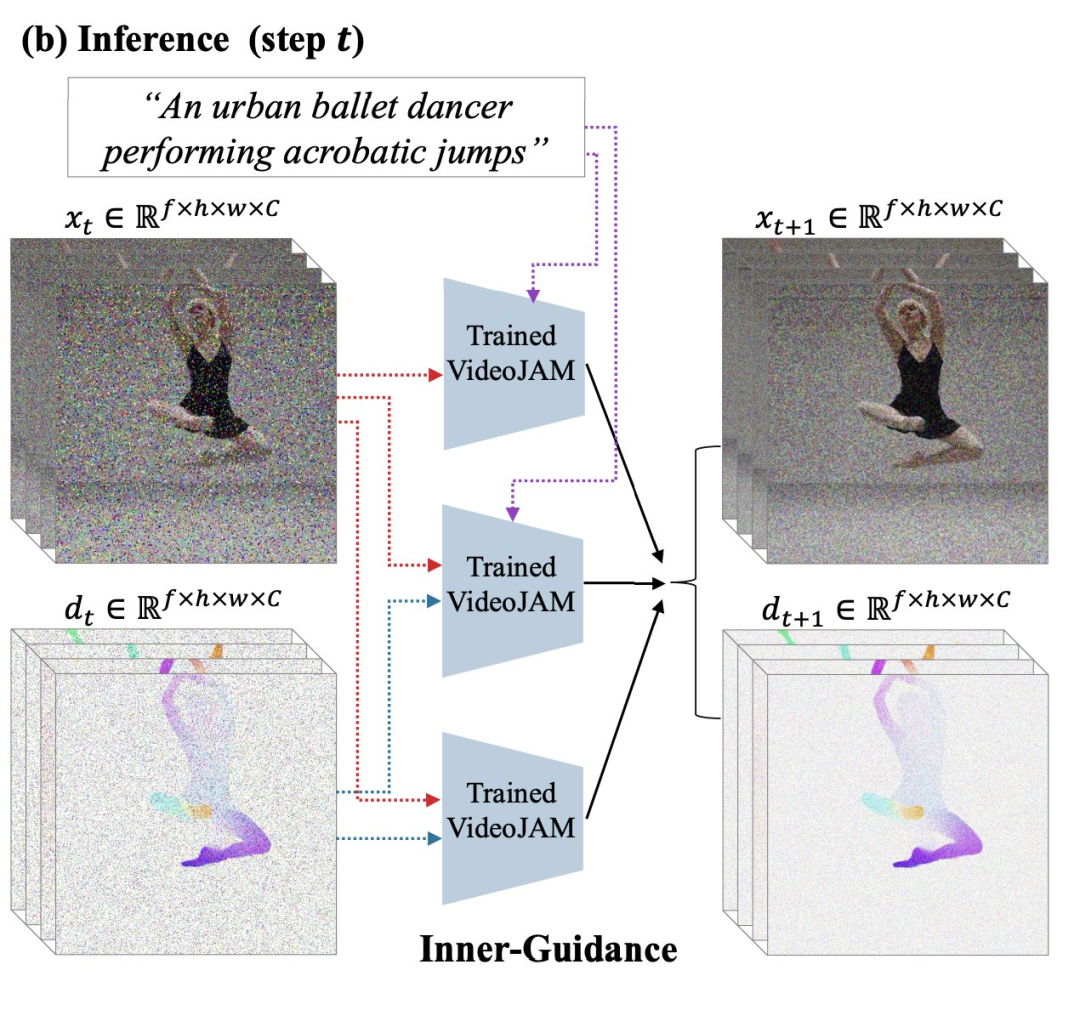

在推理阶段,他们引入了「Inner-Guidance」机制,通过利用模型自身不断演化的运动预测作为动态引导信号,引导生成连贯、逼真的动作。

值得注意的是,VideoJAM框架几乎无需额外改动即可应用于任何视频模型,无需修改训练数据或扩大模型规模。

结果令人惊喜!

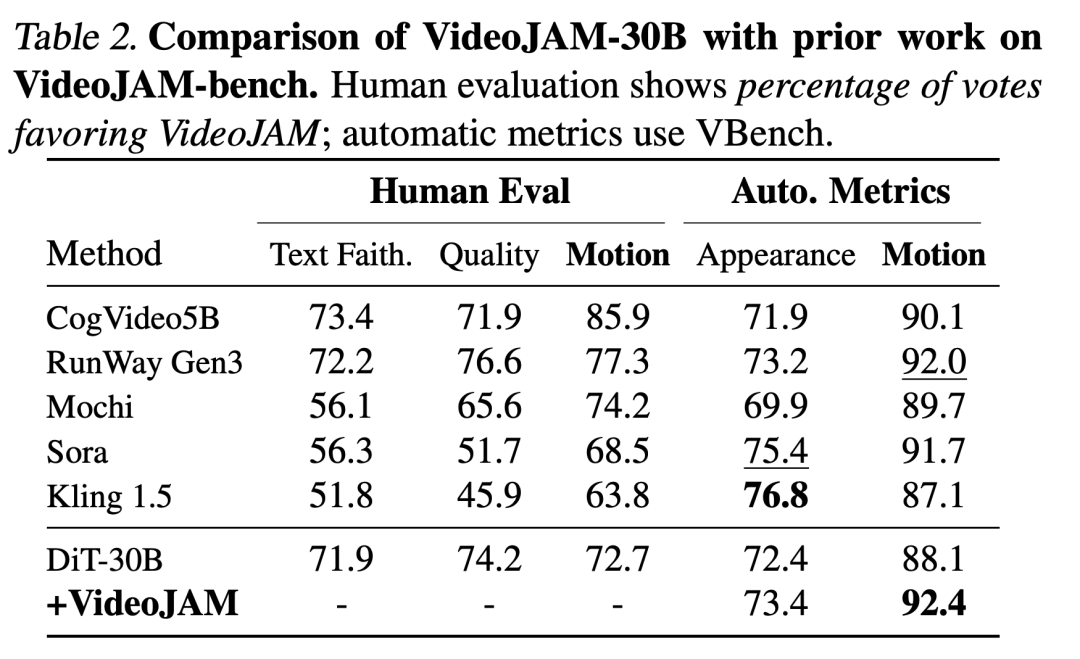

VideoJAM在仅使用其自身训练集中的300万个样本对预训练视频生成模型(DiT)进行微调后,仍实现了卓越的运动连贯性。

在运动连贯性方面,它已经达到了SOTA;在运动质量上,它甚至超越了Sora等专有模型。

Meta团队的研究结果表明,外观与运动之间并非对立,而是相辅相成;当二者得到有效融合时,能够同时提升视频生成的视觉质量与运动连贯性。

复杂运动无比真实

「一位滑板运动员进行跳跃。」

可以看出运动员与滑板在空中的动作结合的十分协调,甚至在踏上滑板时,滑板还有轻微的震动,可谓是十分真实了。

「手指压进一个闪烁的粘液球。」

视频清晰展现了手指与粘液球的粘连状态,生动体现了其粘性。

「一只山羊在山顶一个旋转的球上保持平衡。」

视频中的山羊努力在球上保持平衡,其动作也符合物理法则。

「慢动作特写,厨师切番茄。」

视频中对手指的处理没有明显瑕疵,实属不易。切下的西红柿之间也有着自然的差异。

「一个男孩在生日蛋糕上吹蜡烛。」

下面这个视频需要模型理解小男孩吹气与蜡烛火苗间的逻辑关系。VideoJAM-30B显然处理得还不错。

「一个花瓶在安静的古董店木地板上摔碎。」

这种碎裂的场景十分考验模型对细节的处理,VideoJAM-30B看来也不在话下。

视频AI大PK

定性实验

下图中,同样VideoJAM生成的视频中主体更大,同时跑步姿势也显得更加自然一些。

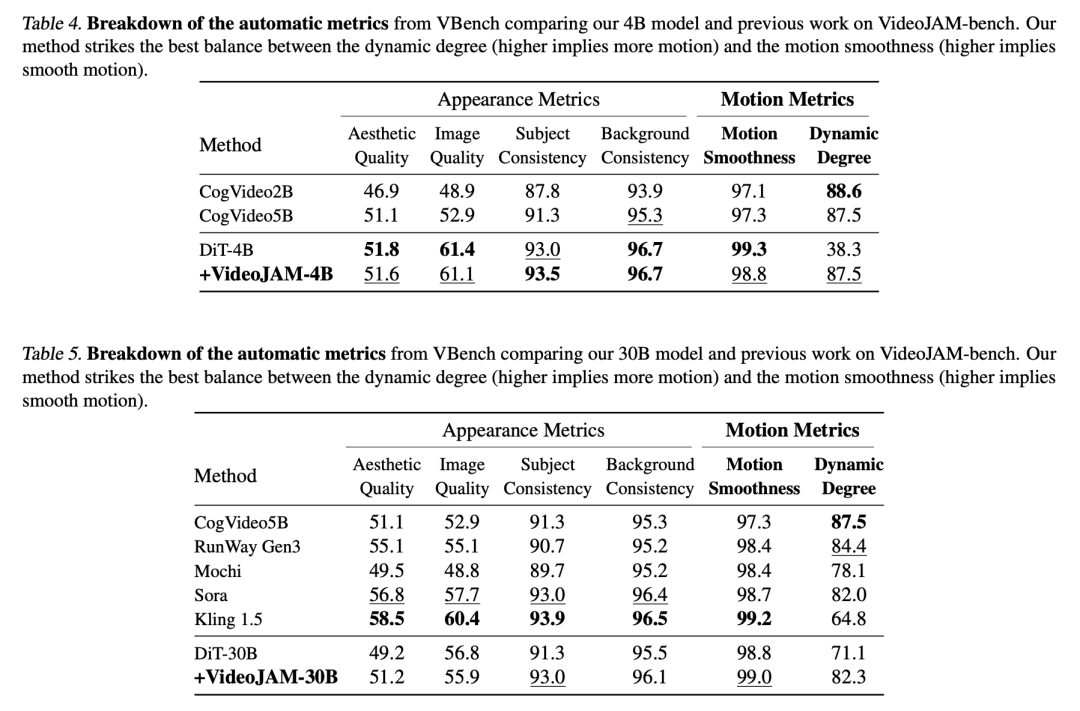

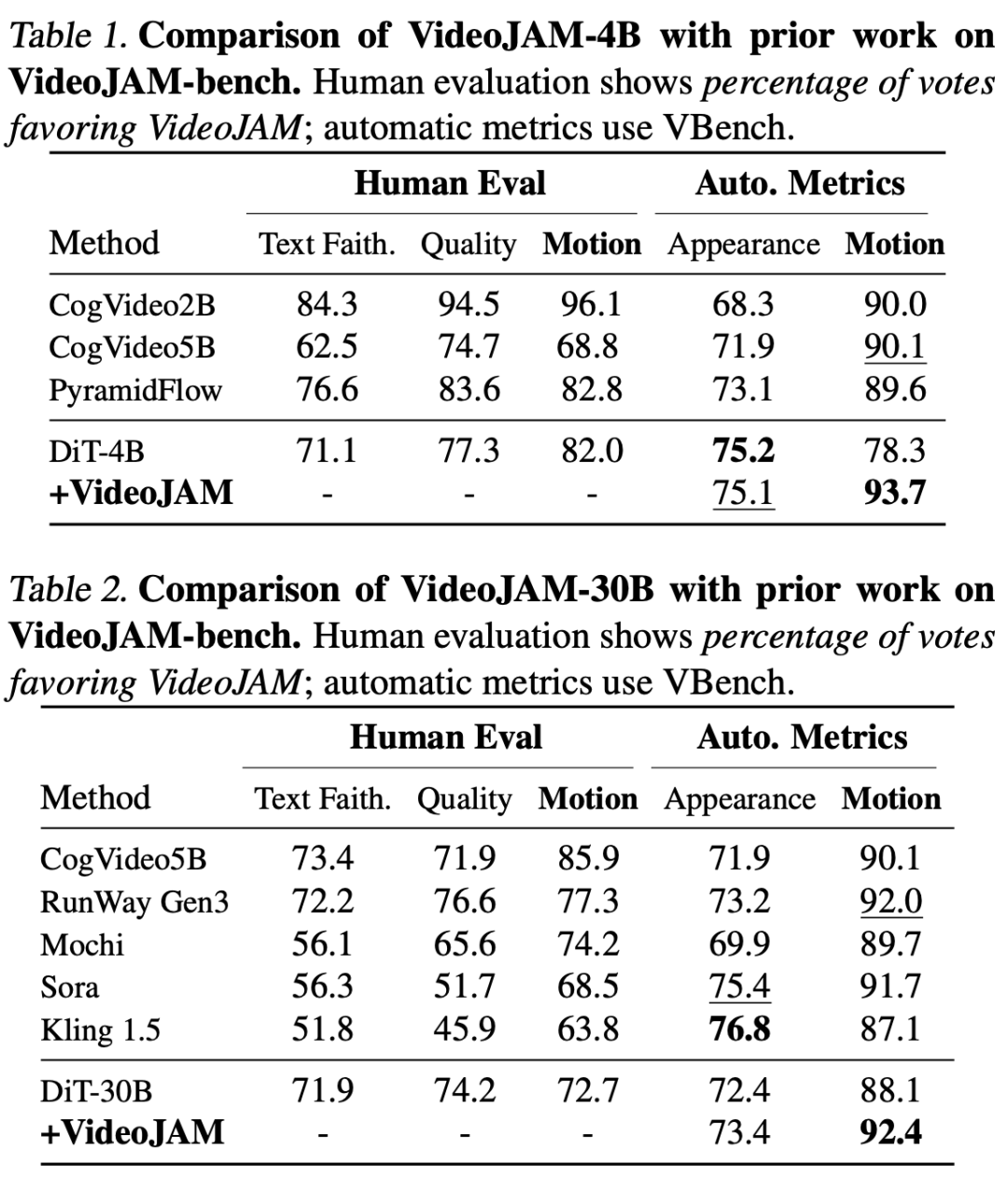

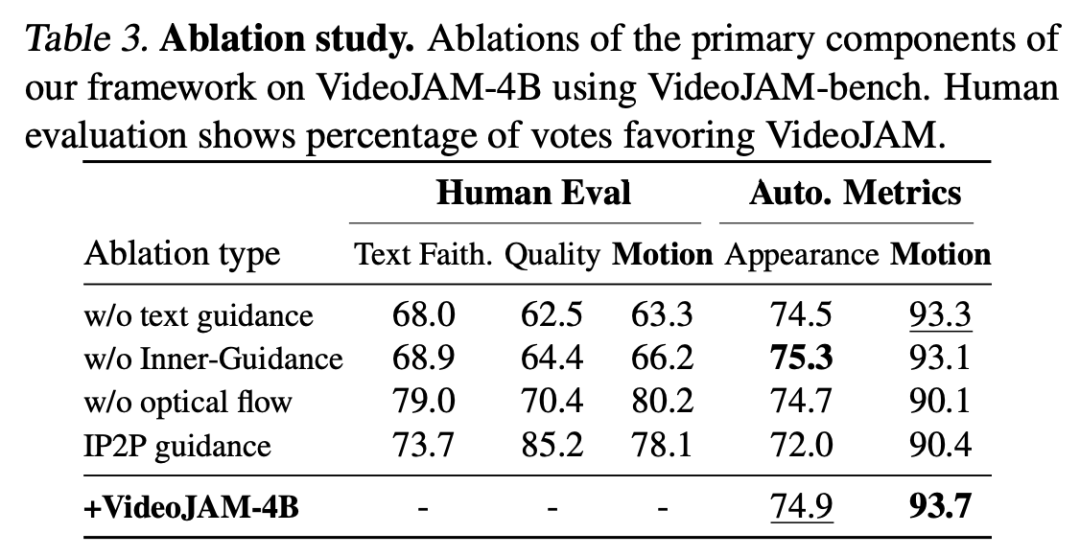

定量实验

消融实验

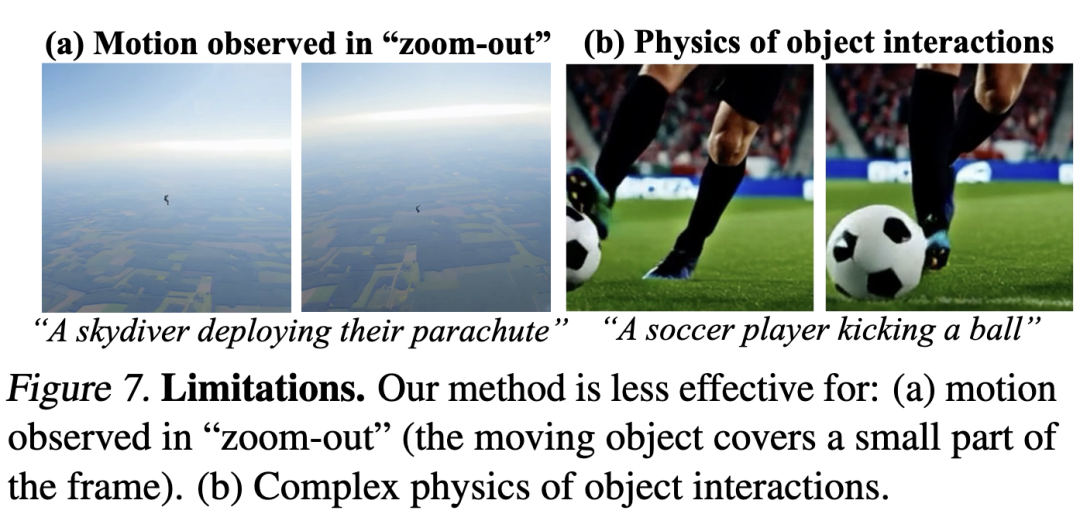

局限性

结论

原文链接:点击前往 >

文章作者:新智元

版权申明:文章来源于新智元。该文观点仅代表作者本人,扬帆出海平台仅提供信息存储空间服务,不代表扬帆出海官方立场。因本文所引起的纠纷和损失扬帆出海均不承担侵权行为的连带责任,如若转载请联系原文作者。 更多资讯关注扬帆出海官网:https://www.yfchuhai.com/

{{likeNum}}

好文章,需要你的鼓励

已关注

已关注

关注

关注

微信号:yfch24

微信号:yfch24

小程序

公众号

社群