{{!completeInfo?'请完善个人信息':''}}

精准高效领先的融资对接服务

微软Azure AI团队宣布开源了一个名为Florence-2的多功能视觉模型,该模型能够提供图像描述、目标检测、视觉定位和图像分割等功能。

摘要

Florence-2有两个版本(230M和770M),在多个知名基准测试中表现出色,零样本学习的表现高于同类模型,总下载量已超过120万。

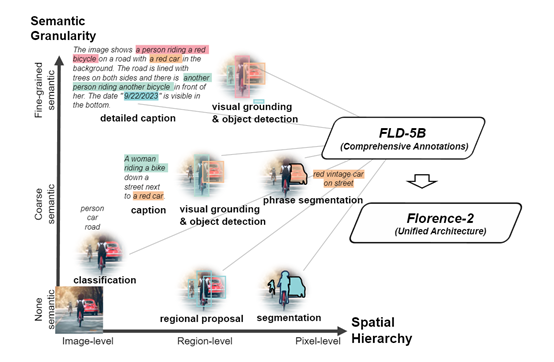

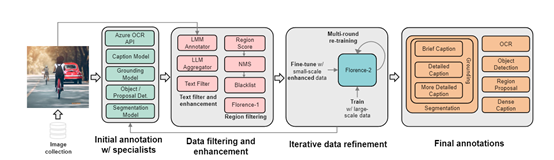

Florence-2使用了超大的数据集FLD-5B,包含1.26亿张图像和54亿个数据标注。该数据集利用自动化图像标注技术和模型迭代结合,确保了数据的高质量和多样性。

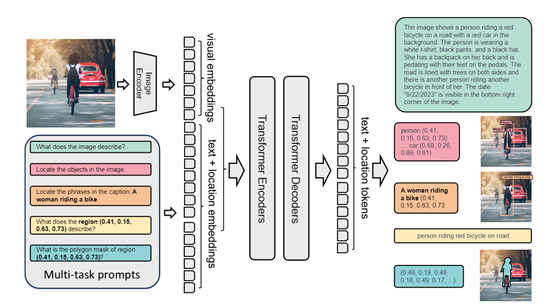

Florence-2基于Transformer,并采用序列到序列(seq2seq)的学习方法,由编码器和解码器组成,编码器负责将图像转换为序列表示,解码器将这些表示转换为输出文本。

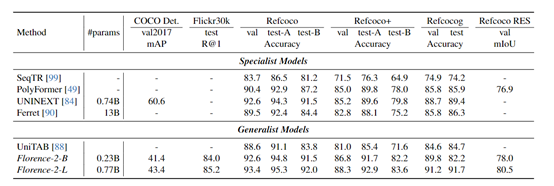

研究人员在COCO、ADE20K、Flickr30k Entities等基准测试平台上对Florence-2进行了综合评估。结果显示,无论是在零样本学习还是微调学习设置下,Florence-2都展现出了卓越的性能,特别是在微调后,其性能与更大参数的专业模型相媲美。

微软Azure AI 团队宣布开源视觉模型——Florence-2。

据悉,Florence-2是一个多功能视觉模型,可提供图像描述、目标检测、视觉定位、图像分割等。

例如,上传一张风景照片,让其解读一下图片的内容;或者上传一张超市货架的照片,让其精准找出牛奶的所在位置。

Florence-2一共有230M和770M两个版本,在多个知名基准测试中零样本的表现非常出色高于同类模型。目前,Florence-2的总下载量已超过120万非常火爆。

开源地址:https://huggingface.co/microsoft/Florence-2-large

在线demo:https://huggingface.co/spaces/gokaygokay/Florence-2

Florence-2之所以拥有如此多的视觉功能和强大的泛化能力,是因为使用了一个超大的数据集FLD-5B,包含1.26亿张图像和54亿个数据标注。

同时该数据集使用了自动化图像标注技术与模型迭代的结合,通过多个模型协作确保了数据的高质量和多样性。

模型架构方面,Florence-2基于Transformer并采用了序列到序列(seq2seq)的学习方法,模型的这一部分由编码器和解码器组成,编码器负责将图像转换为序列表示,而解码器则将这些表示转换为输出文本。

这种设计不仅提高了模型处理任务的灵活性,也使得模型能够以一种统一的方式来处理各种视觉任务。

其他关键模块包括:图像编码器,主要负责将输入图像转换为视觉token嵌入;Florence-2使用DaViT作为图像编码器,这种编码器通过注意力机制捕捉图像特征,为后续的处理提供了丰富的视觉信息。

多模态编码器-解码器,采用标准的Transformer架构,通过自注意力机制实现多模态信息的融合。这种融合使得模型能够更好地理解和生成与视觉内容相关的文本。

位置编码,为Florence-提供了区域级别的空间信息,在目标检测和分割等任务中尤为重要,使得模型能够识别图像中的具体区域。

统一表示则是Florence-2的一大创新亮点,可将不同类型的视觉信息和语言信息包括图像描述、目标检测、视觉定位和分割等,整合到一个统一的框架中,帮助模型在不同的任务之间共享知识,提高学习效率。

为了评测Florence-2的性能,研究人员在COCO、ADE20K、Flickr30k Entities等知名基准测试平台进行了综合评估。

结果显示,Florence-2在零样本学习和微调学习设置下都展现出了卓越的性能,例如,在COCO目标检测和实例分割任务中,它超越了先前的最佳模型,显示了更强的识别精度和分割能力。

在ADE20K语义分割测试任务中,模型也展示了优越的表现,表明其不仅在高层语义理解上有出色表现,对于底层细节的捕捉同样精准。

尤其是在微调后,Florence-2在公共基准测试中的性能与更大参数的专业模型相媲美。

原文链接:点击前往 >

文章作者:AIGC开放社区

版权申明:文章来源于AIGC开放社区。该文观点仅代表作者本人,扬帆出海平台仅提供信息存储空间服务,不代表扬帆出海官方立场。因本文所引起的纠纷和损失扬帆出海均不承担侵权行为的连带责任,如若转载请联系原文作者。 更多资讯关注扬帆出海官网:https://www.yfchuhai.com/

{{likeNum}}

好文章,需要你的鼓励

已关注

已关注

关注

关注

微信号:yfch24

微信号:yfch24

小程序

公众号

社群