{{!completeInfo?'请完善个人信息':''}}

精准高效领先的融资对接服务

11月27日,浪潮信息发布源2.0基础大模型,并一口气开源了1026亿、518亿、21亿三个大模型!而在编程、推理、逻辑这些老大难问题上,源2.0都表现出了令人印象深刻的性能。

国内首个全面开源的千亿模型,来了!

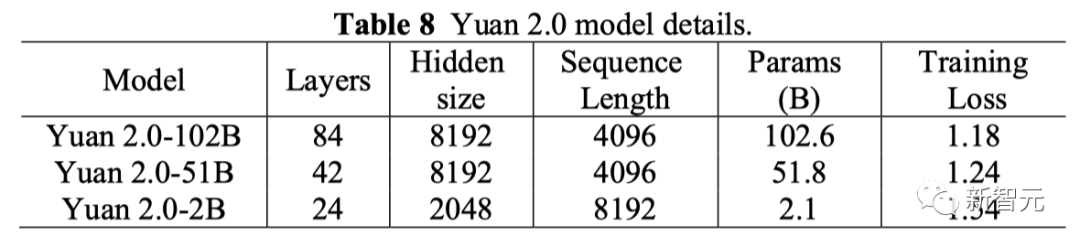

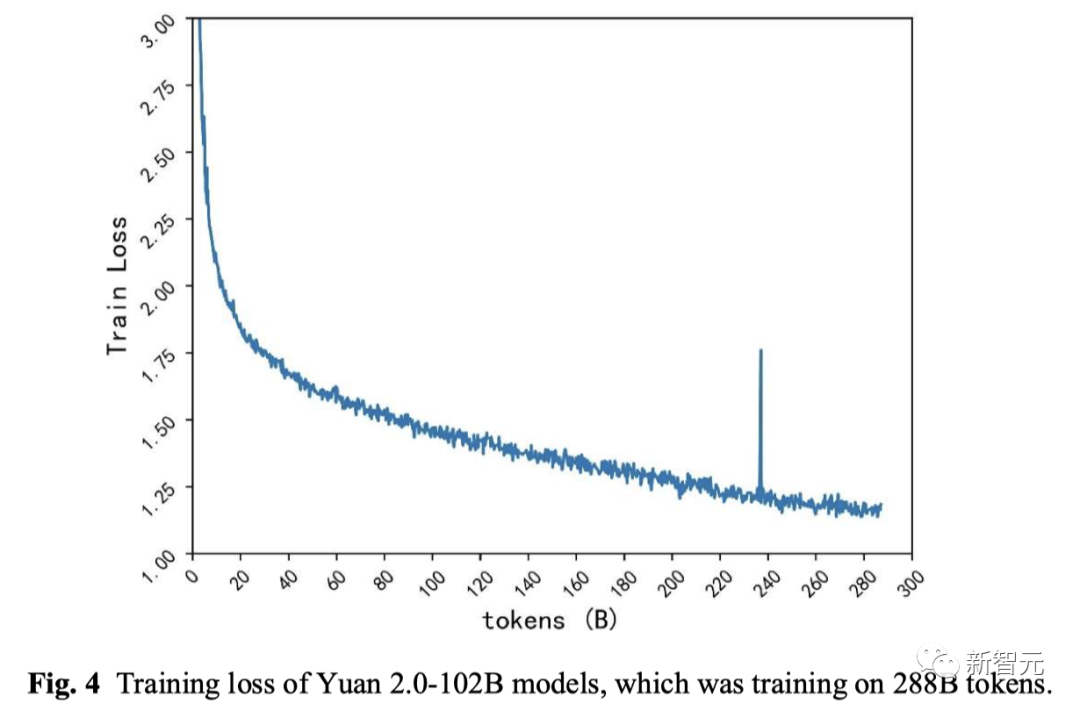

就在昨天(2023年11月27日),浪潮信息正式发布源2.0,无论是2B、51B,还是102B,统统都开源。

这一次,源2.0不仅在数理逻辑、数学计算、代码生成能力上,再次超强进化。

而且,还在算法、数据、算力方面,提出了三项创新。

开源地址:https://github.com/IEIT-Yuan/Yuan-2.0

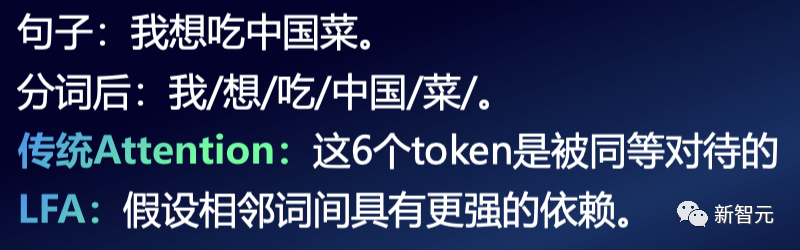

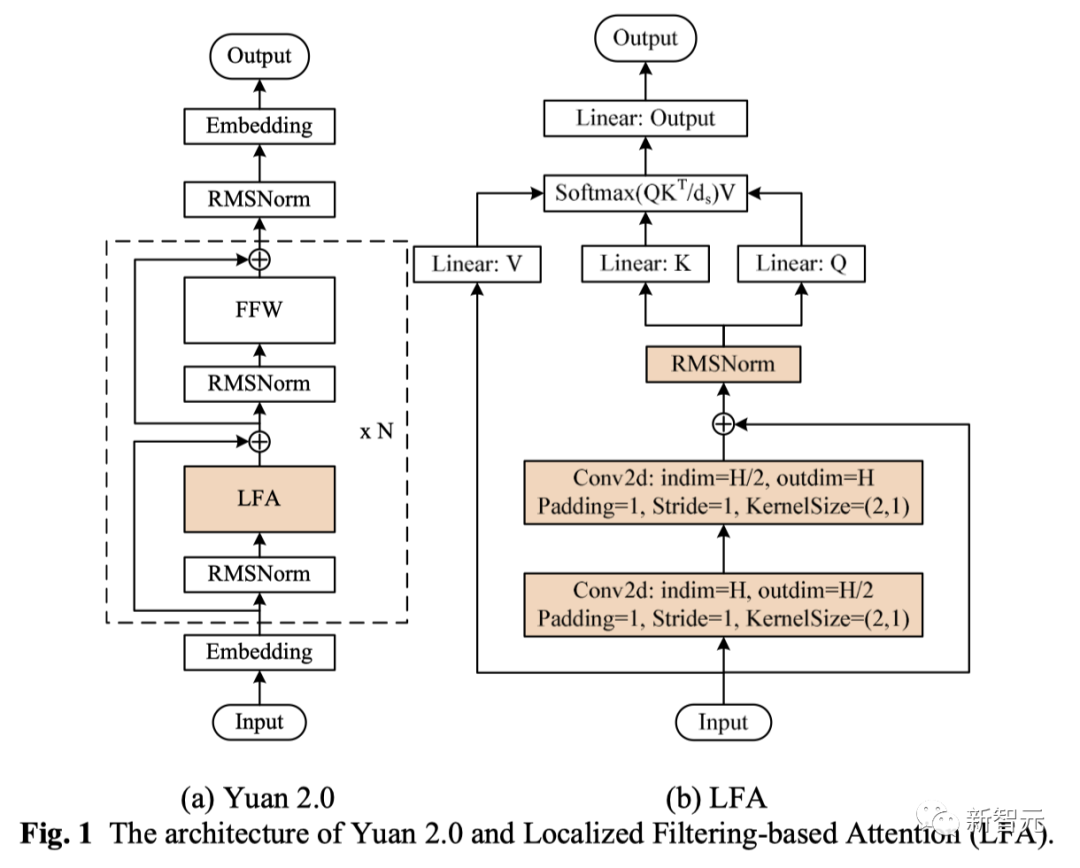

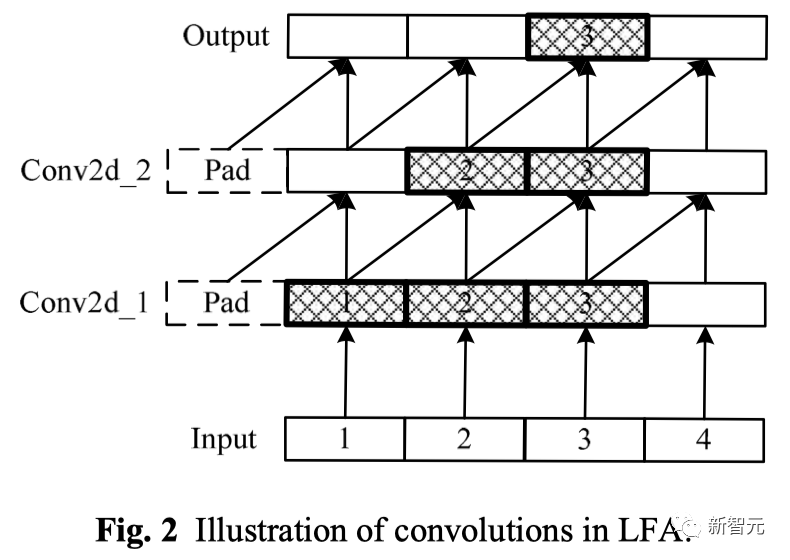

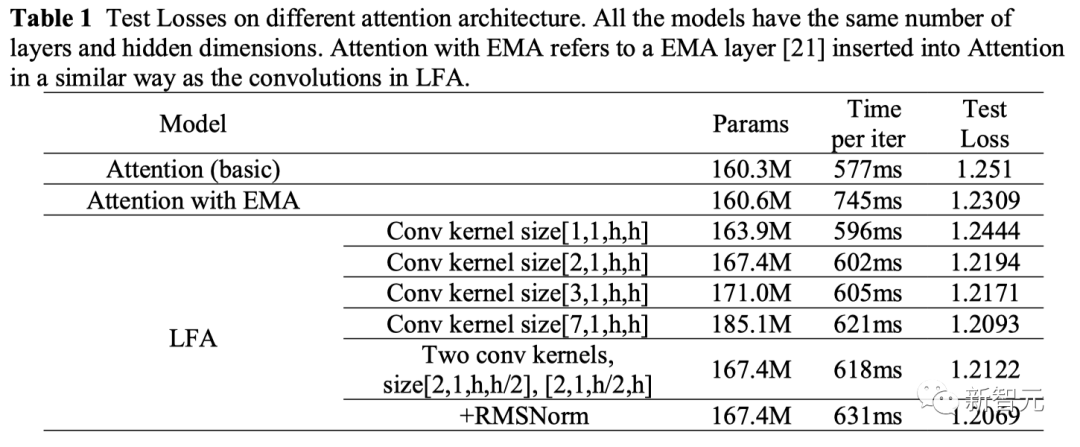

算法方面,源2.0提出并采用了一种新型的注意力算法结构LFA(局部注意力过滤增强机制,Localized Filtering-based Attention),对于自然语言的关联语义理解更准确。

数据方面,源2.0使用中英文书籍、百科、论文等高质量中英文资料,降低了互联网语料内容占比,增加了高质量的专业数据集和逻辑推理数据集。

算力方面,源2.0采用了非均匀流水并行和优化器参数并行的分布式训练方法,显著降低了大模型对芯片间P2P带宽的需求。

源2.0:国内千亿级模型首次全面开源

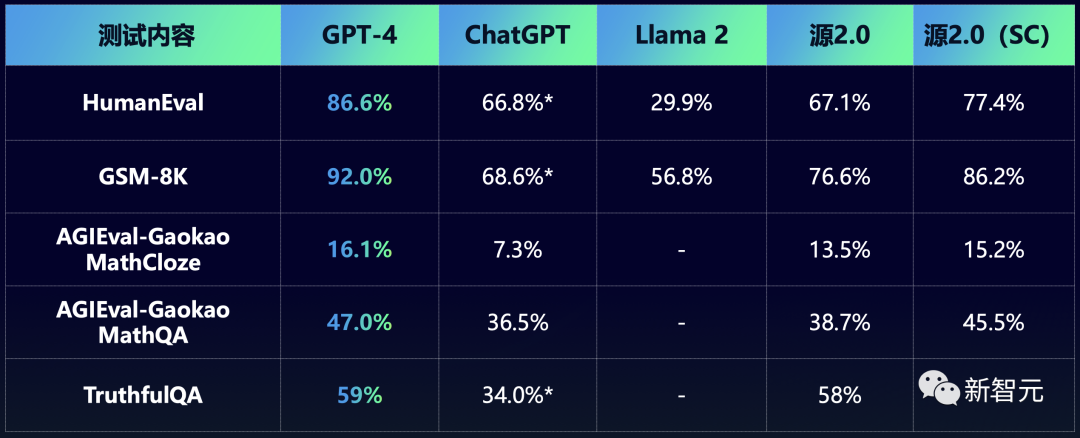

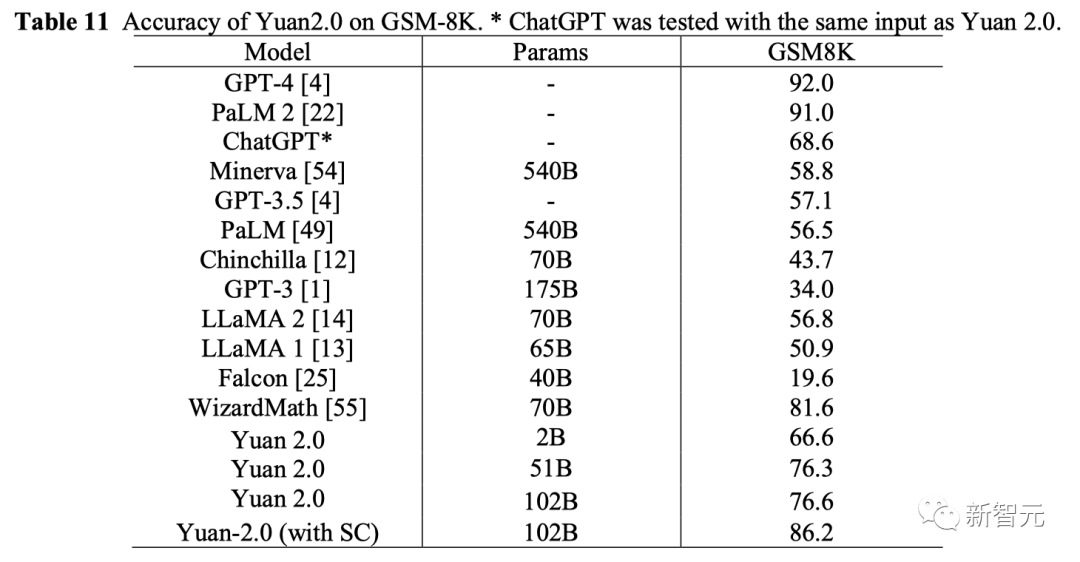

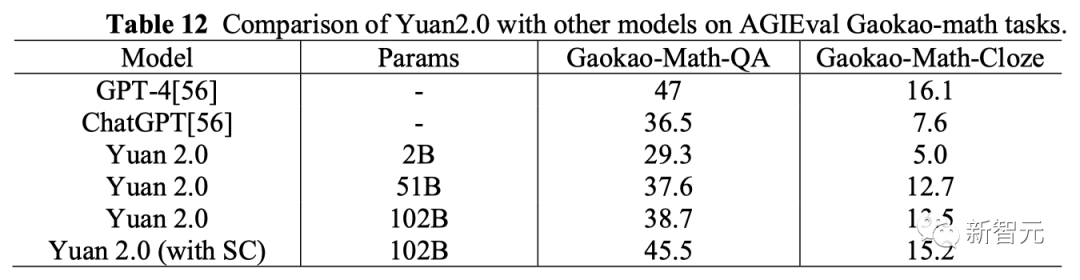

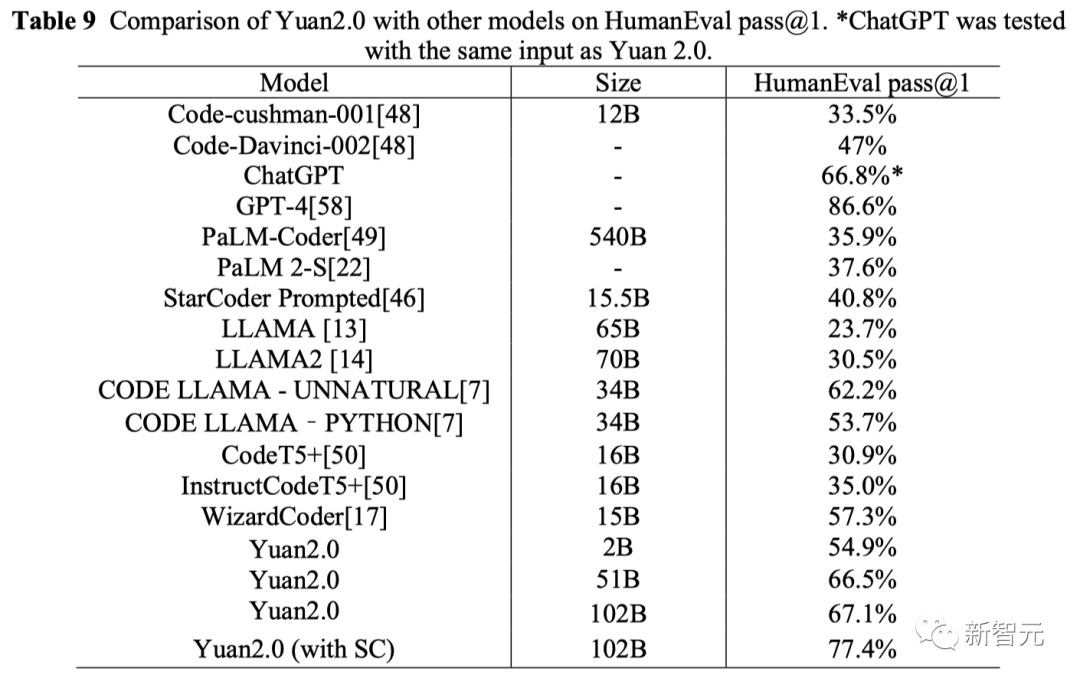

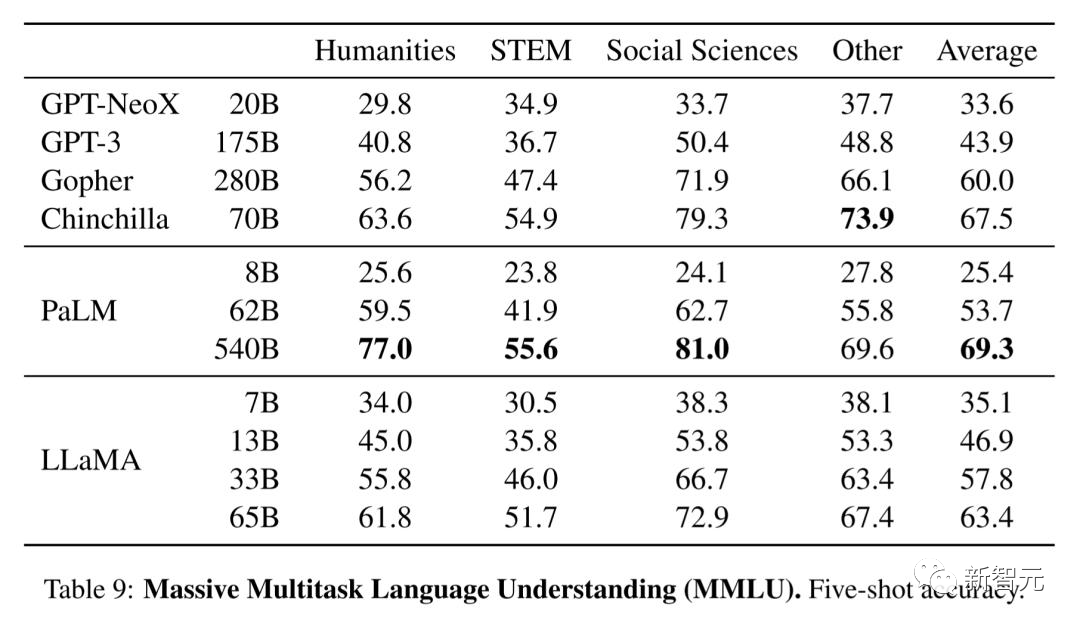

从评测结果来看,不管是在HumanEval上,还是在GSM8K、高考数学上,源2.0模型都超过了ChatGPT,甚至接近GPT-4的精度。

由于源2.0具备生成单元测试的能力,因此团队在HumanEval评估中使用了SC(自洽性,Self-Consistency)方法。也就是,采用由源2.0-102B生成的单元测试作为评判标准,选出成功通过单元测试的候选者。

结果显示,自洽性可以显著提高模型的的性能。比如,HumanEval评测的正确率提升了10.3%,GSM8K提升了9.6%等等。

下面我们就来看看,源2.0的表现到底如何。

数学

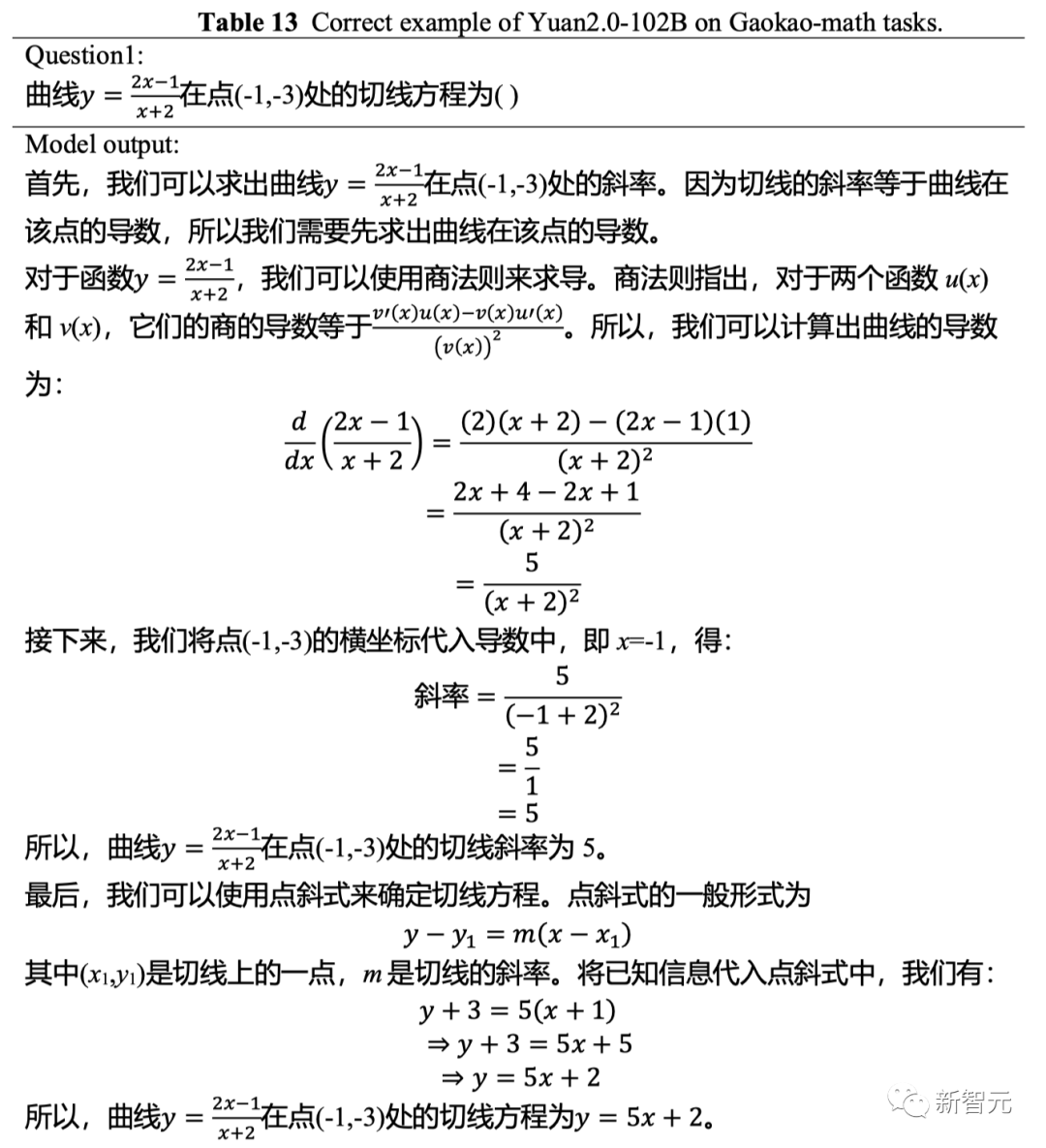

首先是数学能力。

仔细看下面这道高考数学填空题就会发现,它的求解逻辑非常复杂。

这就要求模型不仅具备较好的基础知识,还需要有较好的推理以及计算能力。

从解题过程可以看出,源2.0-102B的推理路径正确,求解过程详尽,符号计算和数值计算均准确。在适当的位置上,模型明确地给出了最终答案,表现出了优异的逻辑推理性能。

根据GSM8K的评估结果,1026亿和518亿参数的源2.0,准确率都超过了76%。

与此同时,21亿参数的源2.0在准确率上也超过了规模大几十倍的Llama,达到了66.6%。

而在AGIEval高考数学任务上,源2.0的得分优于ChatGPT。

代码

代码生成上,源2.0表现出的优异性能让人印象深刻。

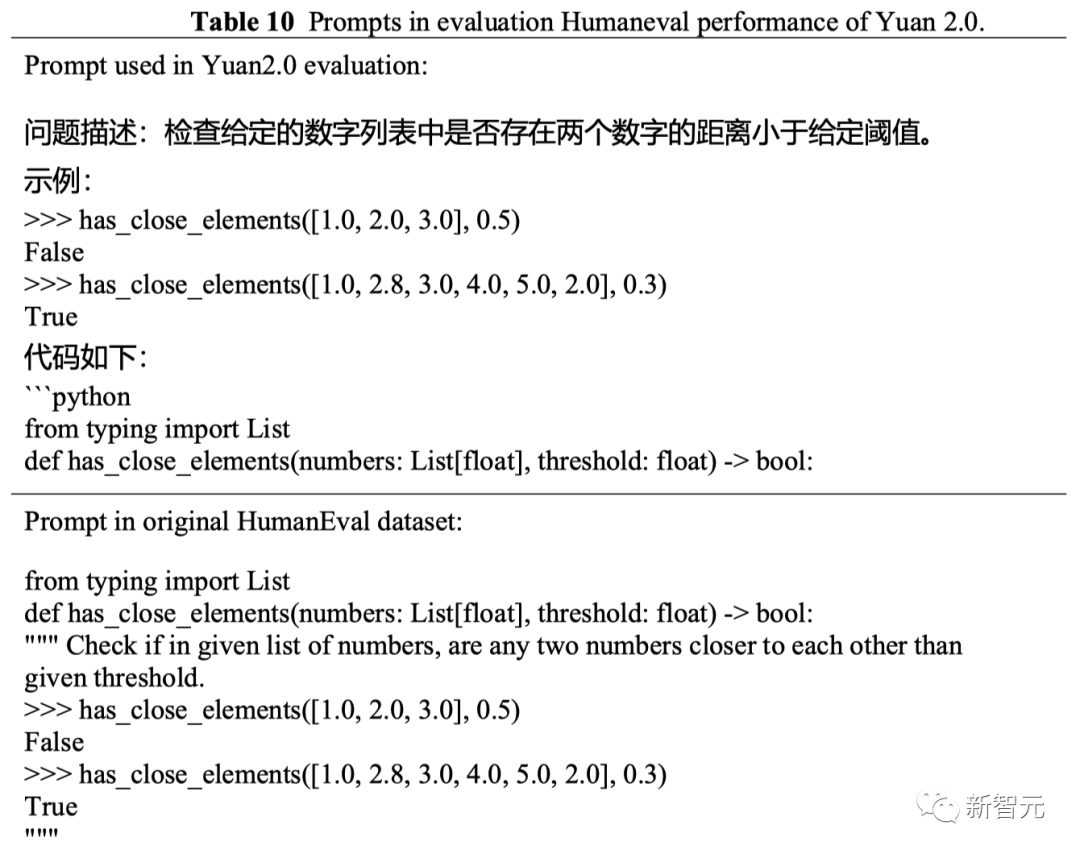

可以看到,下面这道HumanEval评测题出得非常刁钻,即便是经验丰富的程序员,也需要仔仔细细的读题,才能理解清楚。

其中这串拗口的指令「l和l'在不能被3整除的索引处完全相同,在能被3整除的索引处的值,等于l中对应索引的值」意味着需要构建一个子集。

这里,程序员很容易做错,但模型不仅理解了题目,而且还给出了正确的代码。

问题描述:这个函数接收一个列表l,返回一个列表l',满足以下条件:l'与l在不能被3整除的索引处完全相同,而在能被3整除的索引处的值等于l中对应索引的值,但是排好序。

def sort_third(l): non_divisible = [] divisible = [] for i, num in enumerate(l): if i % 3 != 0: else: result = [] d_index = 0 nd_index = 0 for i in range(len(l)): if i % 3 != 0: nd_index += 1 else: d_index += 1 return result结果显示,在HumanEval评测集上,带SC的源2.0的准确率为77.4%,与源2.0的基本测试相比,性能提高了10.3%。

源2.0的详细提示示例如下——

在浪潮信息看来,基础大模型犹如大模型产业的地基,地基的深度和强度,决定了大厦的高度。

依托基础大模型,可以从垂直场景应用有针对性地切入,从而落地行业。

从长远来看,这是我们走向AGI的必经之路。

意味着什么?

而浪潮信息选择开源千亿级模型,也有着更高瞻远瞩的用意。

人们都说,2023年开源社区的荣光应当属于Meta。

今年2月,Meta打造的Llama席卷了整个开源研究领域,掀起了各种大模型爆发新潮——「羊驼家族」就此诞生了。

包括Vicuna、Alpaca、Dolly、RedPajama、Faclon等各种衍生模型泉涌而出。

紧接着7月,升级版的Llama 2面世,再到8月,Code Llama的开源,全都成为点燃生成式AI燎原大势的星星之火。

就在前段时间,Meta公布了当前Llama的生态现状,只能用两个字「震惊」加以形容。

在世界最大开源社区平台Hugging Face上,Llama模型的下载量超过3000万次。其中,仅在过去30天(9月份)内就超过了1000万次。

另外,发布在Hugging Face的Llama版微调模型,已经多达7000+个。

显而易见,Meta开源对整个大模型领域的研究产生了重大的影响,并为未来生成式AI奠定了坚实的开源基础。

一直站在「开源派」阵列的图灵三巨头之一LeCun曾在AI Native大会上称,「我认为开放是必然之路。因为大模型将成为社会人人依赖的基础设施,所以必须是开放的」。

在浪潮信息看来,「源2.0」模型的开源,同样希望能够为中国大模型生态体系的繁荣壮大,增添重要的一笔。

比如,更加轻量的20亿参数模型,不仅具有出色的能力而且还有更小的内存和计算开销,对于终端用户来说便是不错的选择。

众人拾柴火焰高,为了促进生态的繁荣,浪潮信息一方面以优秀的开源模型性能汇聚算力、算法、数据、人才、产业,另一方面以技术创新反哺大模型数据、工具、应用的迭代升级,可谓是目光深远。

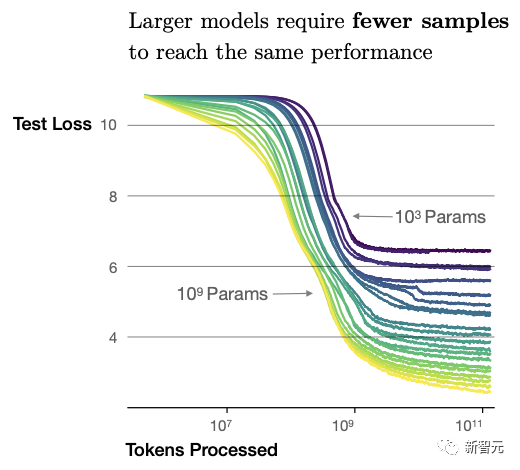

更大参数,更好涌现

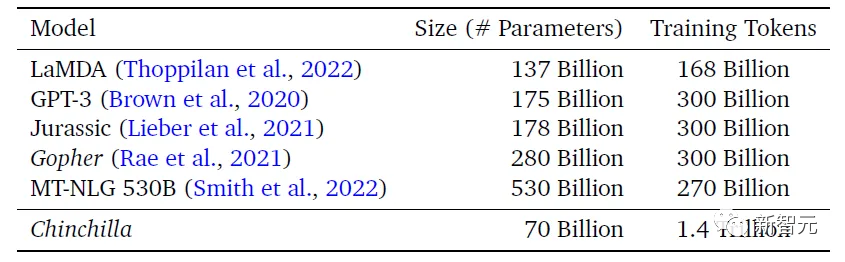

最初,在GPT-4刚刚发布时,可谓是「万人空巷」。

而它之所以能够如此炸裂,是因为在底层智力方面的提升,不仅完全吊打了一众中小模型,甚至直接拿到行业应用中也是如此。

近日,随着OpenAI定制GPT能力的开放,全球在短短几天内诞生了数千款应用,几乎每一分钟就会产生一个新的GPT。

如何实现的?

数据的创新

算法的创新

计算的创新

率先布局,在不断前行中探索

原文链接:点击前往 >

文章作者:新智元

版权申明:文章来源于新智元。该文观点仅代表作者本人,扬帆出海平台仅提供信息存储空间服务,不代表扬帆出海官方立场。因本文所引起的纠纷和损失扬帆出海均不承担侵权行为的连带责任,如若转载请联系原文作者。 更多资讯关注扬帆出海官网:https://www.yfchuhai.com/

{{likeNum}}

好文章,需要你的鼓励

已关注

已关注

关注

关注

微信号:yfch24

微信号:yfch24

小程序

公众号

社群