{{!completeInfo?'请完善个人信息':''}}

精准高效领先的融资对接服务

腾讯在AI领域快速追赶,继推出AI工作台ima.copilot后,12月3日发布了AI视频生成功能“混元(HunYuan Video)”,并在腾讯元宝APP内提供体验。

摘要

发布初期,用户有三次体验机会,随后增加到每天六次体验机会。腾讯对算力进行了优化,缩短了视频生成的等待时间,从最初的几小时减少到不超过十分钟。

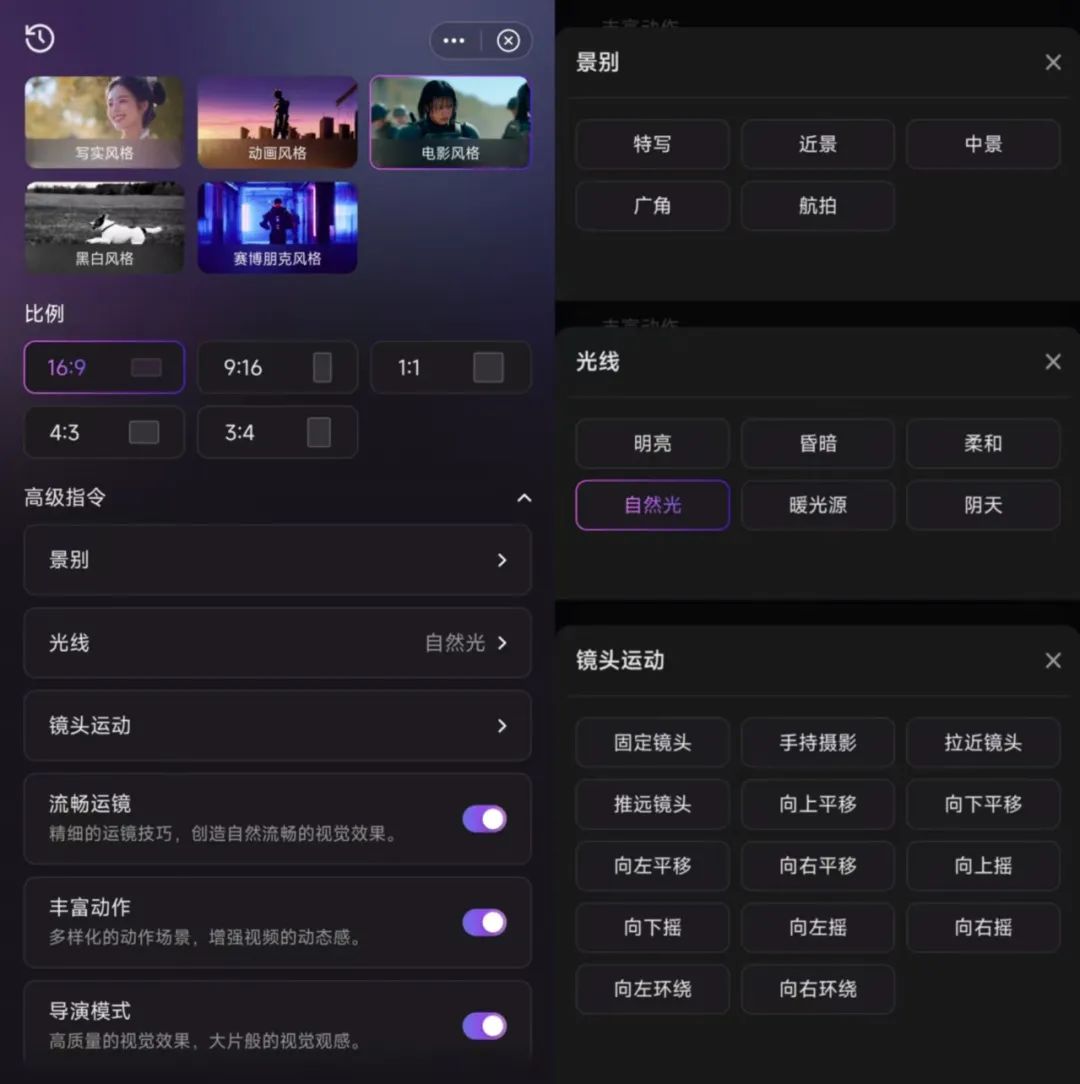

混元视频模型提供了全面的“高级指令”调节选项,包括风格、比例、景别、光线和运镜五个类别,提高了视频生成的可玩性,允许用户进行细节设置。

混元模型在人物面部表情、手指运动等细节处理上表现出色,减少了AI视频的“不自然”感。尽管如此,AI视频生成在四肢细节生成上仍是挑战,混元模型在这方面表现较好。

腾讯开源了参数量达130亿的HunYuan Video模型,旨在吸引更多用户和开发者,共同探索基于模型的创新应用和玩法,推动AI视频技术的商业化和规模化应用。

年末补课AI的腾讯,在各条细分赛道快速追进。

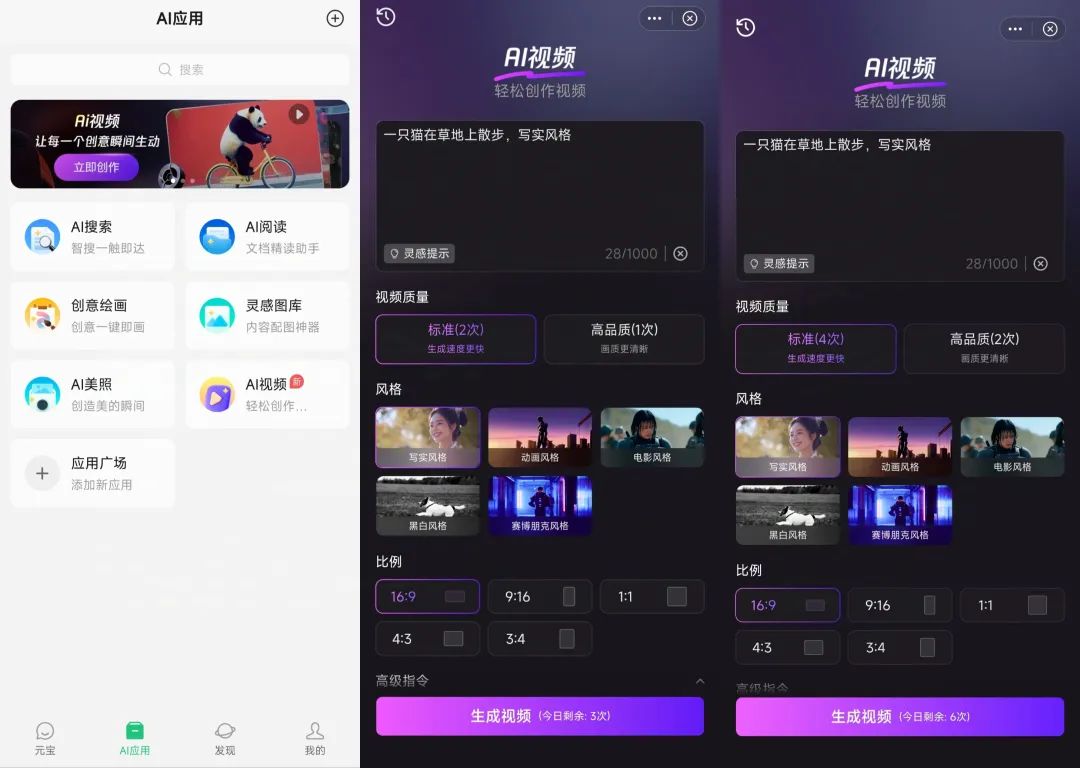

继11月推出AI工作台 ima.copilot 之后,12月3日,已有剧透的AI视频生成功能终于被鹅厂放出,官方名称仍是混元(HunYuan Video),目前可在腾讯元宝APP内体验,

3号发布当天,用户仅有三次体验机会,包括一次高品质生成;4号腾讯增加了体验次数,改成了每天四次标准+两次高品质,总共六次,直接翻了一倍。

腾讯元宝-AI应用-AI视频

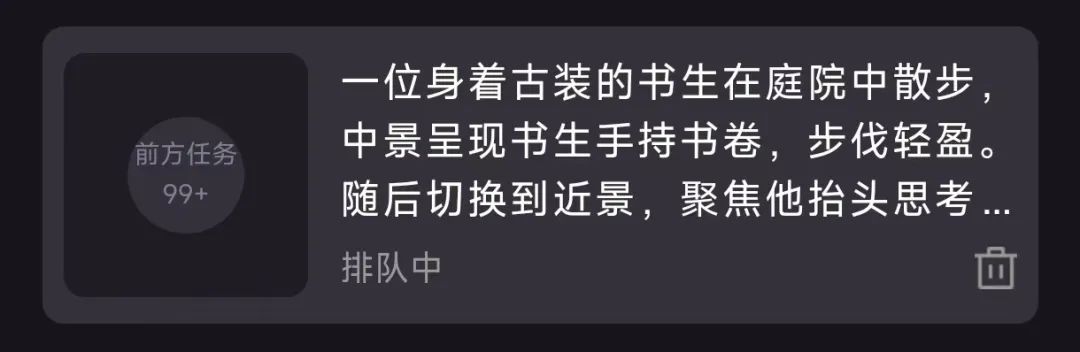

直接看演示:模型成功理解了提示词中外部全景到内部近景的视角切换,质量也比较不错。

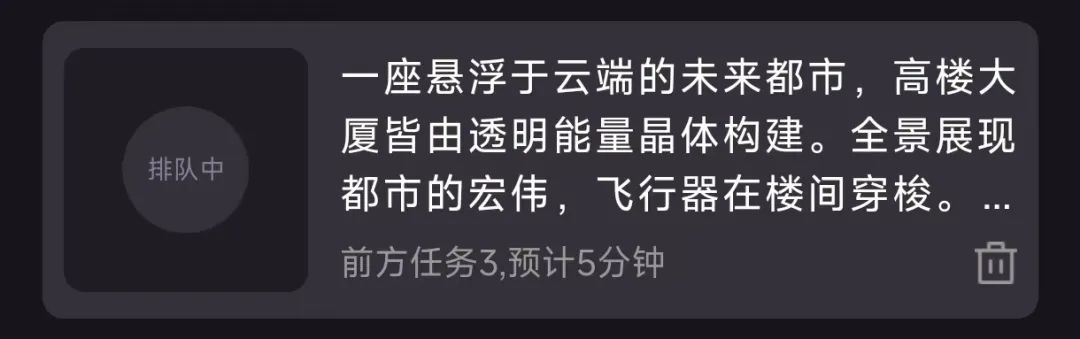

提示词:一座悬浮于云端的未来都市,高楼大厦皆由透明能量晶体构建。全景展现都市的宏伟,飞行器在楼间穿梭。随后拉近镜头至一个神秘的科技实验室,一位年轻的女科学家身着银色防护服,正在操作一台散发着幽蓝光芒的大型仪器,特写她专注的眼神与仪器上闪烁的复杂数据符文,整体画面以冷色调为主,科技感。

必须承认,大厂就是大厂,技术能力方面事儿大可不必担心。

可玩性很高的模型

视频生成大模型曾在今年年中经历过一段时间的集中发布,大厂和初创公司接连掏出了自家版本的“Sora”。

行业短暂沉默几个月之后,腾讯进场似乎预示着新一轮国产Sora竞争的开启(豆包和Kimi近期也都有动作)。

只不过,或许是用户等得太久热情太高,又或许是腾讯算力准备不够充足,混元大模型生成视频的等待时间,一度格外漫长:之前体验过的模型最多十几分钟也就出来一条了,而发布当天的混元大模型,想体验需要做好等几个小时的准备。

12月3日 等待超过一小时

好在,后续官方应该是对算力进行了优化,或者单纯加开了一些服务器,等待时间过长的问题已经解决。

12月4日 等待不超过十分钟

以及,生成的视频质量在线,不然用户体验真的会严重扣分。

提示词:一位身着古装的书生在庭院中散步,中景呈现书生手持书卷,步伐轻盈。随后切换到近景,聚焦他抬头思考,镜头以平移运镜为主,跟随书生的行动轨迹。

与目前市面上已有的快手可灵、字节即梦、MiniMax海螺和智谱清影相比,腾讯混元在“高级指令”里给出的调节选项最为全面,包含风格、比例、景别、光线和运镜五个类别。

上面这段提示词,本身已经给了镜头视角的设置(可惜这次AI并没有做出来切换效果),在下面的“高级指令”选项里,除了打开所有能增强质感的开关外,只额外设定了一个“自然光”。

混元AI视频 高级指令界面

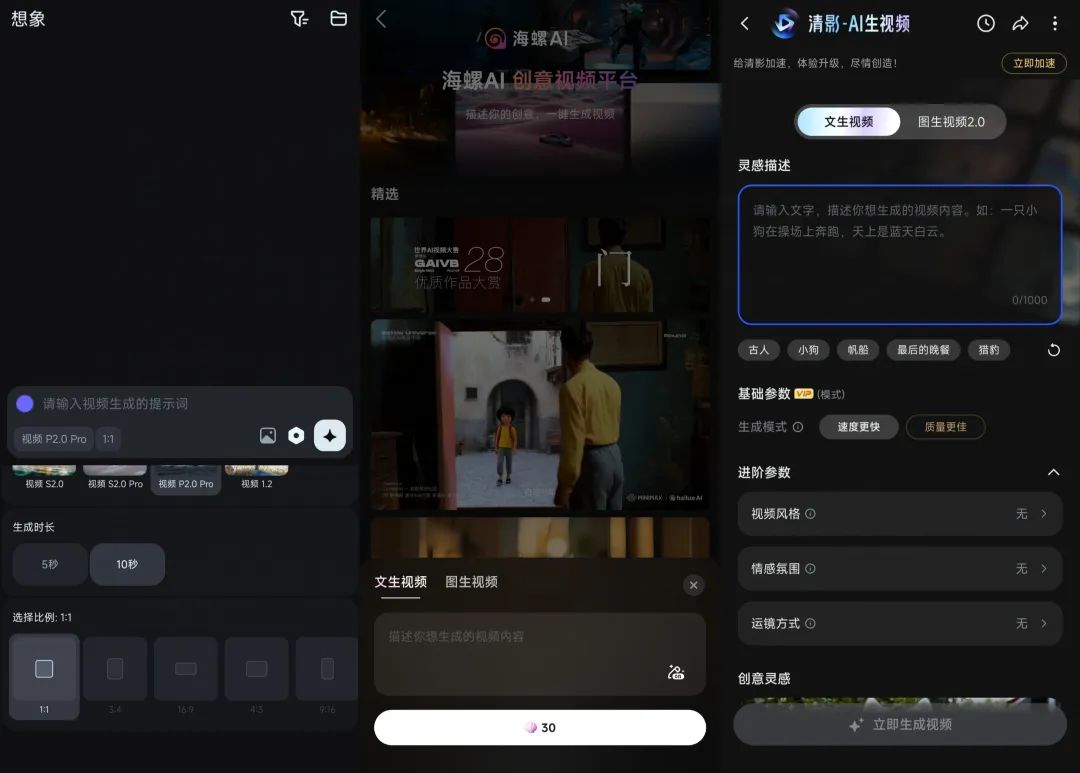

同赛道其他产品,虽或多或少都会给一些预设选项,但对比混元都相对有限。

从左至右依次为即梦、海螺和清影

更新后的可灵1.5模型,在PC端选择高品质模式下,额外增加了运镜控制选项,标准模式目前不支持调节。

可灵1.5

显而易见,混元视频模型最大限度的把AI创作的控制权开放给了用户,有点类似能在手机里找到的“开发者模式”,用户可以对很多进行细节具体设置,再交由AI执行命令。

这种自由度带来的可玩性,理论上会非常高。

比如,用不同画风和景别跑同一段提示词,最终给出的视频会有明显区别,但帽子等等细节又都能呈现。

赛博朋克 近景 明亮

写实风格 广角 柔和

提示词:车水马龙的时尚都市街头,站着一位背着专业相机、身着个性潮牌服饰且头戴时尚棒球帽的年轻摄影师,他微微仰头,寻找拍摄充满现代活力与时尚气息的城市街头夜景。

混元模型对这些预设的执行力尚可,要求基本都加进去了,第二段还用了类似延时摄影的效果,这种“可玩性”带来的好处就是,用户可以拿同一段提示词组合出很多完全不同的视频内容,获得更大的调整空间。

这带来的应用潜力,非常可观。

AI视频

离能用还有多远?

当然,如果真的要AI视频可用,风格是只是大面,画面一致性等等细节还是最终的决定因素。

从以往大量案例中不难看出,手部等四肢部位的生成一直是视频生成模型的薄弱环节。AI在生成这些细节时常常出现问题,例如人物出现六根手指,或者四肢部分扭曲变形等情况。

本身AI对肢体细节的刻画就是难点,在文生图模型上已经颇为明显,而视频生成对动态性和连续性的要求,又进一步放大了这种困难。

惊喜的是,诸如手部畸变、面部不自然等问题,在混元模型中几乎没有出现,前面几个案例中,人物面部在运动过后未有太多明显不合逻辑的变化,人物的动作姿态,身体其他部位与物体及周围环境存在的交互关系也比较合理。

下面这个片段构图看起来并不复杂,但细节绝对可以算得上惊艳。

提示词:一位住在木屋的中年人,睡醒后从床上坐起来,双手抱头,表情失落。近景 / 自然光 / 固定镜头

人物面部表情,手指运动和双手抱头的过程,毛发细节的处理近乎以假乱真。

模型需要对细节有更深入的理解和精准的把握,才能生成趋近现实的人物动作。这种细节部分的稳定连贯,让混元生成的视频前后画面一致性相当不错——主体、场景、风格、运镜、光效等方面都能保持一致,观感上就会比较流畅、自然,减少画面的“AI味”,那种肉眼可见的突兀变化。

不过,以目前视频模型所能生成的短短几秒内容为样本,包括画面也包括时长,AI视频未来一段时间内仍会是以技术探索为主,或者在一些例如广告片的设计中作为补充元素,离独当一面还有不小距离,成规模的商业化仍有难度。

既然难以直接实现盈利,不妨先把用户和开发者生态尽可能打开,腾讯就选择开源了这个参数量达130亿的HunYuan Video模型。

吸引更多用户和开发者,集思广益探索基于模型所能衍生出的创新应用与新颖玩法,或许才是破局的关键所在

原文链接:点击前往 >

文章作者:AI蓝媒汇

版权申明:文章来源于AI蓝媒汇。该文观点仅代表作者本人,扬帆出海平台仅提供信息存储空间服务,不代表扬帆出海官方立场。因本文所引起的纠纷和损失扬帆出海均不承担侵权行为的连带责任,如若转载请联系原文作者。 更多资讯关注扬帆出海官网:https://www.yfchuhai.com/

{{likeNum}}

好文章,需要你的鼓励

已关注

已关注

关注

关注

微信号:yfch24

微信号:yfch24

小程序

公众号

社群