{{!completeInfo?'请完善个人信息':''}}

精准高效领先的融资对接服务

字节跳动的研究人员发布了一种创新的量化方法,该方法不需要访问实际图像数据,仅依赖模型自身的自监督信号。

摘要

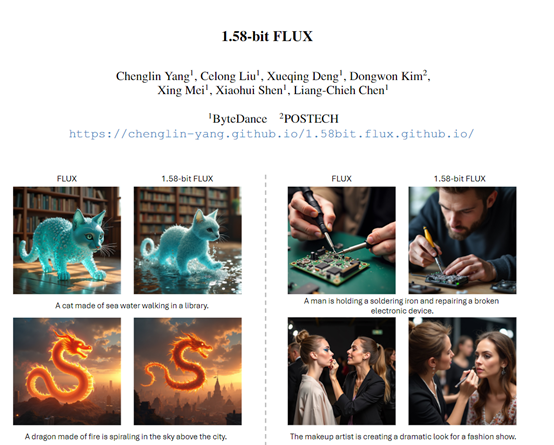

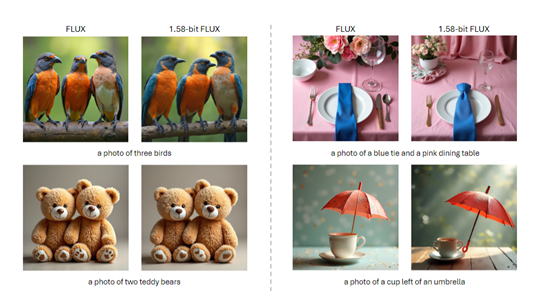

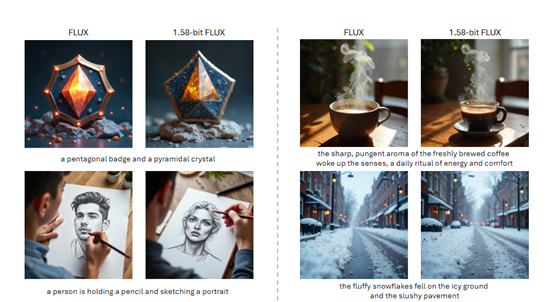

研究人员在开源文生图像模型FLUX上进行实验,成功将模型量化到1.58位权重,使用{-1, 0, +1}三种值表示,而不是更高精度的浮点数。

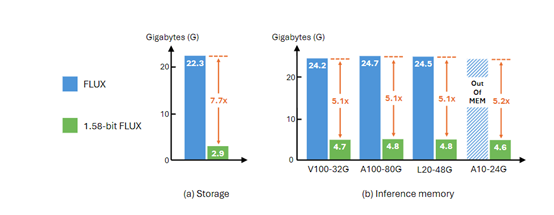

尽管模型被量化到极低的位数,但在生成1024 x 1024分辨率图像时,性能与未量化模型基本一致。此外,存储减少了7.7倍,推理内存减少了5.1倍。

研究团队采用了PTQ方法,避免了在训练过程中对模型进行繁琐的微调操作,直接对预训练好的模型进行量化处理,节省了计算资源和时间。

在GenEval数据集和T2I CompBench验证分割上评估了FLUX和1.58位FLUX,量化后的模型在多个指标上与原始FLUX相当,证明了量化模型保持性能的优势。此外,研究人员计划将这一量化方法开源,以便更多受算力、内存限制的人员实现更高效的模型推理。开源项目地址为:1.58bit.flux。

Midjourney、DALLE 3、SD3等模型的出现,使得文生图像赛道实现了快速发展。但这些模型的参数非常大,在推理、生成的过程中占用了大量内存,极大限制了使用场景和设备。

为了解决这一难题,字节跳动的研究人员发布了创新的量化方法,不需要访问任何实际的图像数据,仅依赖模型自身的自监督信号即可。研究人员在著名开源文生图像模型FLUX进行了实验。结果显示,成功将FLUX的模型量化到1.58位权重,仅用{-1, 0, +1}三种值就能表示而不是更高精度的浮点数。

尽管模型被量化到如此低的位数,但在生成 1024 x 1024 分辨率图像时,性能仍与未量化的模型基本一致。为了支持1.58位的运算,还开发了一个专用的计算内核,存储减少了 7.7 倍,推理内存减少了5.1倍,极大降低了对存储、内存的需求。

先为大家简单介绍一下什么是量化技术。量化是一种模型压缩技术,主要通过减少模型权重的精度来降低模型的大小和计算需求。在传统的深度学习模型中,权重通常以32 位浮点数存储,这占用了大量的内存空间。

量化技术通过将这些权重映射到更少的位表示,比如8 位或更低,从而显著减少了模型的存储需求。量化还可以减少模型在推理时的计算量,因为整数运算比浮点运算更快、更高效。

在1.58-位FLUX的研究中,量化的应用达到了一个新的巅峰,研究人员没使用常见的8 位或更低的精度,而是将FLUX模型中的权重量化到了1.58 位,仅用三个数值就能表示。虽然高性能量化方式极大地压缩了模型的大小,但也有一个很大难题,如何在低精度下保持模型的性能。

为了实现这一目标,研究团队采用了一种后训练量化(PTQ)的方法。传统的 QAT 方法通常需要在模型训练过程中引入额外的量化操作,并对模型进行微调。这一过程往往涉及到复杂的训练机制调整和大量额外的计算资源投入。模型需要在训练过程中不断适应量化带来的精度损失,通过反向传播等技术手段来调整模型参数,以尽量减少量化对模型性能的影响。

而PTQ无需在训练过程中对模型进行繁琐的微调操作,直接聚焦于预训练好的模型进行量化处理,可以充分利用已经训练完成的 FLUX.1 - dev 模型所包含的丰富训练数据和强大能力,避免了重新训练所带来的巨大计算开销和时间消耗。

为了进一步确保 1.58 位 FLUX模型在推理过程中的高效性,研究团队在 PTQ 方法的基础上,还开发了专门针对 1.58 位操作优化的自定义内核。这个内核在模型推理过程中发挥着至关重要的作用。通过优化数据的存储结构和访问模式,使得模型在运行时能够以更低的内存占用实现高效计算。

在不同类型的 GPU 上进行测试时,1.58 位FLUX 借助该自定义内核实现了推理内存使用量的大幅减少,减少倍数超过 5.1 倍。在推理过程中,模型能够更加有效地利用内存资源,降低了内存溢出的风险,提高了系统的整体稳定性和运行效率。

此外,自定义内核还通过优化计算流程,减少了不必要的计算步骤和数据传输,显著提高了模型的推理速度,降低了推理延迟。例如,在处理复杂图像生成任务时,1.58 位 FLUX 能够更快地响应用户请求,生成高质量的图像结果提供更好的使用体验。

在性能评估方面,研究人员在GenEval数据集和T2I CompBench验证分割上评估了FLUX和1.58-位 FLUX。评估方法遵循官方的图像生成流程,生成的图像分辨率为1024×1024。结果显示,1.58 位 FLUX在多个指标上与FLUX相当,这证明了量化后的模型在保持性能方面的优势。

在效率方面,1.58-位 FLUX在模型存储和推理内存方面都显示出显著的效率提升。例如,与FLUX相比,1.58-位 FLUX将检查点存储减少了7.7倍。这一成果是通过将1.58位权重存储为2位有符号整数实现的,从而将它们从16位精度压缩。

在推理延迟方面,1.58-位 FLUX在不同GPU上的表现也有所提升。尤其是在性能较低但适合部署的GPU上,例如,L20和A10,1.58-位 FLUX的推理延迟得到了显著改善。

研究人员表示,这个量化方法很快就会开源,帮助更多受算力、内存限制的人员来实现更高效的模型推理。

原文链接:点击前往 >

文章作者: AIGC开放社区

版权申明:文章来源于 AIGC开放社区。该文观点仅代表作者本人,扬帆出海平台仅提供信息存储空间服务,不代表扬帆出海官方立场。因本文所引起的纠纷和损失扬帆出海均不承担侵权行为的连带责任,如若转载请联系原文作者。 更多资讯关注扬帆出海官网:https://www.yfchuhai.com/

{{likeNum}}

好文章,需要你的鼓励

已关注

已关注

关注

关注

微信号:yfch24

微信号:yfch24

小程序

公众号

社群